Posizionamento con status code 610

by 23 Novembre 2022 9:49 2.7K views0

Ultimo aggiornamento 19 Aprile 2024

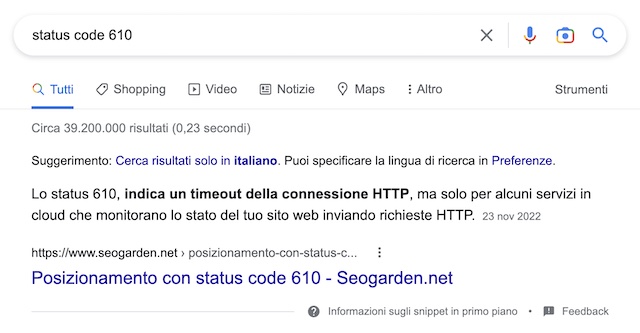

L’articolo che stai per leggere è un test come quelli che faccio spesso, in questo caso su un argomento volutamente campato per aria. Volevo semplicemente vedere se riuscivo a ottenere uno snippet in evidenza su Google per una query riferita a uno status code che almeno rispetto alla SEO non esiste.

In effetti sì, ci sono riuscito. Quindi occhi aperti, perché con buona pace dello screenshot sottostante, ciò che segue è opera di fantasia.

L’articolo nasce dall’osservazione di un fenomeno visibile attraverso le statistiche di scansione per come le vediamo in Search Console. In particolare studiando un sito web da milioni di visite al mese, mi sono accorto che i crawler di Google si spostano su vari tipi di risorse a seconda di come si comportano rispettivamente i produttori dei contenuti da un lato e gli utenti dall’altro.

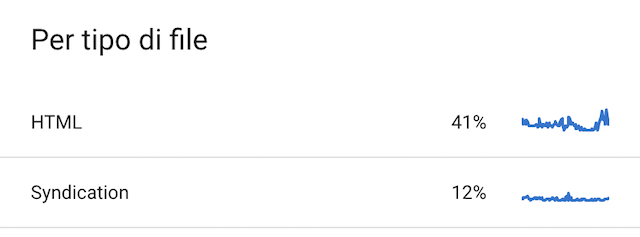

A patto che i primi e i secondi non coincidano, quindi nella misura in cui non parliamo di un sito web che funzioni sugli User generated content, avremo che le risorse di scansione andranno molto più frequentemente verso l’aggiornamento di risorse già esistenti, piuttosto che sulla rilevazione di pagine nuove, mentre per quanto riguarda il tipo di file, avremo una predominanza delle risorse HTML in status 200, poi via via troveremo le dipendenze JS / CSS, le immagini, i JSON.

Ora, mi è capitato di notare che per alcuni siti web verticali di tipo aziendale, tra cui blog e siti e-commerce, in alcuni momenti ho trovato – per pochissimo tempo – uno spostamento di finalità delle richieste, dall’aggiornamento delle pagine già rilevate e scansionate alla rilevazione di pagine nuove, anche se in realtà non ne erano state prodotte.

Questo era strano. Se un sito e-commerce pubblica i prodotti nuovi solo un paio di volte l’anno, ci aspetteremmo una scansione più frequente sulle pagine già esistenti e meno frequente su quelle nuove, invece in certi momenti accadeva il contrario.

E perché accade?

Accade quando entrano in gioco i feed, o meglio quando ne rallentiamo (più o meno volontariamente) l’accesso mandandoli in codice stato 610 e contestualmente sottomettiamo una nuova sitemap nella search console, accertandoci che Google prenda atto di tutto. Quando successivamente alla sottomissione della sitemap, i feed torneranno raggiungibili, si originerà uno “scossone” che per un momento andrà a sbilanciare gli equilibri di scansione producendo un deepcrawl e forzando il bot a rileggere tutto il sito web in profondità.

Lo status 610, indica un timeout della connessione HTTP, ma solo per alcuni servizi in cloud che monitorano lo stato del tuo sito web inviando richieste HTTP. Se dopo aver inviato una richiesta HTTP non viene ricevuta alcuna risposta entro 5 secondi, tali servizi determinano che si verifica un timeout della connessione. In questo caso alcuni servizi restituiscono un codice di stato 610, mentre solitamente lo status è 503 o più spesso 504 a seconda dei casi.

Inizialmente credevo che tale pratica potesse portare benefici quando il motore di ricerca si “addormenta”, cosa che accade spesso sui siti web recenti e con poche pagine che appunto fanno fatica a entrare in indice. Mi sono accorto però, che a fronte di questa situazione, le pagine più recenti vanno a migliorare i posizionamenti in modo netto, ottenendo visibilità per parole chiave con volumi di ricerca importanti. Addirittura la visibilità statistica cresce talmente tanto da comportare una crescita del punteggio di autorità fino a 4 punti, cosa che normalmente richiede un incremento importante nel numero dei backlink da siti web autorevoli.

Status code 610, cosa ho scoperto

Nel momento in cui rendi nuovamente raggiungibili i feed, contestualmente alla sottomissione delle sitemap, le statistiche di scansione riportano un incremento per tipo di file “syndication” che arriva quasi a raggiungere le scansioni sulle pagine HTML.

È in quel momento che arriva il ribaltamento dell’attenzione verso la rilevazione delle pagine nuove ed è lì che si verificano le condizioni da cui arrivano i grossi passi in avanti sul posizionamento nei motori di ricerca.

Successivamente con il normalizzarsi della situazione, i posizionamenti tendono a ribilanciarsi fino a tornare ai livelli precedenti, ma sempre senza comportare alcuna penalizzazione. È un boost per tutti i contenuti recenti e si genera in questo modo, almeno così mi è capitato di osservare in più di un caso.

Semmai provate e fatemi sapere.