Copertura indice di Google [Search Console]

by 2 Febbraio 2018 7:190

Ultimo aggiornamento 19 Aprile 2024

Nei giorni scorsi i colleghi sono stati subissati da centinaia di email riguardanti la search console. Google ha così annunciato la buona novella, vale a dire l’introduzione su vasta scala della nuova versione “beta” della piattaforma attraverso cui possiamo far dialogare il nostro sito web direttamente con l’indice di Google e leggere informazioni importanti sullo stato delle scansione e dell’indicizzazione dei contenuti.

La search console è lo strumento senza il quale avrei forse più difficoltà a fare una buona analisi SEO. In questa nuova versione Google ci offre molte più informazioni sulla copertura indice. Vediamo di preciso cos’è questa copertura e come inquadrare le nuove informazioni.

Cos’è la copertura indice

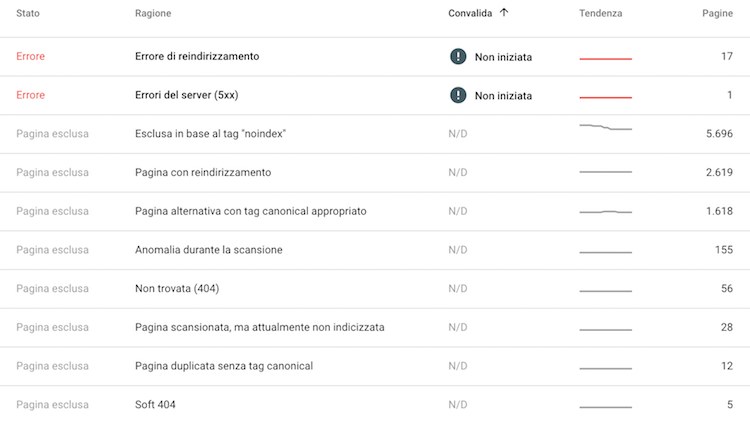

Se lo stato dell’indicizzazione ci fornisce il valore complessivo delle pagine che Google ha registrato e che tiene ancora in pancia, l’index coverage può essere inteso come il modo in cui i contenuti si distribuiscono all’interno dell’indice. Se ad esempio il tuo sito presenta 10.000 pagine allo stato dell’indicizzazione, è possibile che di queste 10.000 solo 500 siano ritenute utili per i lettori, mentre le altre potrebbero presentare problemi. La copertura dell’indice è la nuova funzione della search console che segmenta le pagine del tuo sito web rispetto ai problemi di scansione e per ciascun segmento indica quali sono le pagine interessate dal singolo problema. Si tratta di un aiuto importantissimo per leggere, anzi, per vedere il modo in cui Google serve il nostro sito web, senza utilizzare gli strumenti e le pratiche che noi SEO siamo costretti a utilizzare per ricavare le stesse informazioni.

Mentre la “vecchia” search console mostra solo i codici 4XX, 5XX e soft 404, la nuova estende l’analisi alle pagine in noindex, alle 3XX, alle pagine con canonical appropriato, a quelle duplicate, ma prive di canonical e a quelle scansionate, ma non indicizzate. Come se poi non bastasse ci dice anche quali sono le pagine per ciascun gruppo, fino a coprire l’intero indice di Google per il nostro sito.

Attendibilità dei dati

Fantastico, meraviglioso, invece no. Al momento tutte queste informazioni non sembrano essere molto più che una bella dichiarazione di intenti. Nelle intenzioni di Google c’è l’offrire una piattaforma che semplifichi il lavoro dei SEO e di chi in generale cura il proprio progetto web, ma nella realtà dei fatti, per quanto ho potuto constatare analizzando una decina di profili search console nuovi, le pagine segnalate in noindex spesso sono 404, così come quelle mostrate in quanto reindirizzate o duplicate senza canonical. Le pagine scansionate, ma attualmente non indicizzate in realtà risultano indicizzatissime, infatti sono visibili in serp e presentano una normale copia cache. In sostanza Google segnala cose che non corrispondono al riscontro visivo, attirando le ire dei più esigenti sul piano tecnico (se fai un aggiornamento fallo bene), ma allo stesso tempo l’indulgenza di chi sa che la “search” è un processo che richiede tempo e continui aggiustamenti.

Il futuro della search console

Credo che occorrerà ancora tutto il 2018 per affinare il processo di segmentazione dei dati e probabilmente non sarà mai preciso, come del resto non lo è tutt’ora la vecchia search console, che mostra talvolta errori 404 dovuti a pagine ormai rimosse da anni, che a loro volta non prendono più link da nessuna parte. Ecco, sarebbe bello che in Google riuscissero a scollare dagli indici le informazioni su queste pagine fantasma che invece rimangono appiccicate da qualche parte nei meandri oscuri dei loro data center sparsi sul pianeta (chissà quale). Insomma, più deep crawl, più risorse, meno innovazioni a metà.

Noi invece continuiamo inesorabilmente a utilizzare Screaming frog e analytics in match con la vecchia e (più o meno) sana search console. I dati ricavati incrociando più piattaforme filtrate, rimangono ad oggi lo strumento di analisi che restituisce i dati più accurati per cogliere lo stato di salute di un sito web rispetto a scansione e indicizzazione.

Tutti sono necessari, nessuno è determinante preso da solo.

Rimango in attesa di sviluppi di tipo wowowo, come te.